从WAIC上爆火的功夫机器人,看到这家央企的具身智能「真功夫」

还记得那个会「功夫」的机器人吗? 今年 4 月份,一个名叫「功夫 boy」的机器人火出了圈,它的一招一式颇有练…

还记得那个会「功夫」的机器人吗? 今年 4 月份,一个名叫「功夫 boy」的机器人火出了圈,它的一招一式颇有练…

7月28日,上海世界人工智能大会WAIC上,阿里云正式推出了首款专为AI Agents打造的”超级…

「算力是智能时代的土壤,其规模与效率决定着数字未来的疆界。」 7 月 28 日,2025 年世界人工智能大会上…

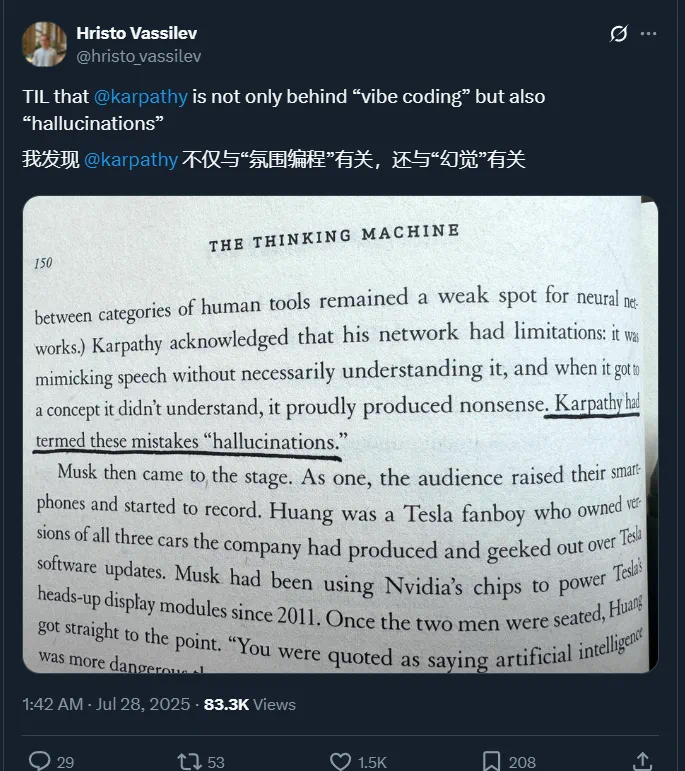

取名大王 Karpathy。 万万没想到,「幻觉」这个词,竟然是 AI 大牛 Andrej Karpathy …

在三个月前,OpenAI 研究员 Shunyu Yao 发表了一篇关于 AI 的下半场的博客引起了广泛讨论。他…

7月28日,在世界人工智能大会论坛上,蚂蚁数科正式发布金融推理大模型Agentar-Fin-R1,为金融AI应…

2025年7月28日,在2025 WAIC世界人工智能大会期间,容联云于上海世博展览馆成功承办“重塑升力·AI…

在2025世界人工智能大会(WAIC 2025)期间,作为“最懂大模型的AI基础设施”,商汤大装置围绕“技术底…

编辑丨& 2024 年,ChatGPT、Sora、Stable Diffusion 等人工智能生成内容…

7 月 27 日,在 2025 世界人工智能大会期间,快手可灵 AI 举办了以 “生成式 AI 应用元年” 为…